广达董事长林百里指出,现在是AI的黎明时刻,意味即使现阶段仍夜色朦胧,但已露出曙光,不久将来会大放光明,对于台湾电子业来说也是如此。过去台湾仰赖台积电为护国神山,各界期待能够在台积电之外,会有护国群山,如今上述的期待终有成真机会。

台湾电子业曾在PC时代大放异彩,在全盛时期,全球9成以上PC由台厂负责生产,然随着移动通讯时代来临,与Wintel(微软+英特尔)擦身而过,台湾电子业也跟着沉潜,不时有闪亮之星冒出头,却未能像当年PC时代群雄并起,如今AI提供了台湾电子业全面发展的良机。

消费电子旺季退位 只剩AI独占鳌头

过去台厂仰赖的PC,近年发展已经停滞,甚至在「倒退噜」,直至百年一见的COVID-19(新冠肺炎)疫情席卷全球,才导致PC回春,随着疫情结束,PC再度回跌,且经历1年清库存,即使业界宣称回到健康水位,仍然不见终端销售有起色,旺季不旺已是既定事实。

智能手机同样饱受库存调节与消费不振冲击,DIGITIMES Research估,2023年智能手机出货仍将年减6.9%。近期才发表的苹果(Apple)iPhone 15系列,发表前业界估将不及往年的9,000万支备货量,发表后又被批评无亮点,如今已有投资机构指称,iPhone出货的延迟天数也较往年少。

过去苹果发表iPhone前的3个月,国内沿海工厂备货生产,各厂抢工景象已不再出现,有一说法是,品牌厂的供应链受中美冲突影响外移,另一说法是,iPhone的生产备货量已不如以往。然从发表前到发表后各界反应,都指明一件事:连iPhone都已无力回天。

掌握全球晶圆先进制程的台积电,一向是产业指路明灯。台积电总裁魏哲家在7月下旬的第2季法说直言,需求比想像差,库存调节至何时难预估,要看经济状况而定。台积电看好且能见度高的只有AI,未来5年,预估相关营收将以年复合成长率近5成起跳。

英业达为全球服务器主机板出货龙头,每5片主机板就有1片出自英业达。负责主机板业务的英业达企业电脑事业群总经理林书如指出,在2022年之前,AI服务器出货占比极小,在2023年2月以后才突然爆红,几乎每家客户都在询问。

ChatGPT掀起生成式AI热潮

AI被谈论多年,过去10年发展尤其快速,2012年神经网络(CNN)、2017年Transformer模型到2020年GPT3,都推动AI发展往前跃进一大步,然多数民众其实无感。直到ChatGPT出世,众人才真正感受到AI就在你我身边。

ChatGPT推出2个月,使用人数已经破亿,TikTok花了约9个月时间达到1亿用户,而Instagram花了2年半。这是史上在全球成长最快速的消费者应用程序,现在每月造访量仍超过15亿人,也是全球前20大网站之一。

不只一般大众,企业机构也有同样反应。广达耕耘智能医疗多年,负责智能医疗业务的技术长张嘉渊,在2023年AI年会时指出,当跳进智能医疗市场,才发现里面水很深,然近期受惠于ChatGPT,医疗机构才展现出对AI的高度兴趣。

ChatGPT背后的大型语言模型(LLM),不论对数据、运算架构的需求都极大。根据统计,GPT-NeoX-20B的基础模型,参数量达20B,数据量达825GB;若是LLaMA,参数量达65B,数据量达1.4TB;而若是GPT-3.5,由于未公布,因此推估其参数量高达175B,数据量达45TB。

因应庞大数据,不论训练、推论,都需要强大的运算架构支持,上述的GPT-NeoX-20B,其训练所需要的GPU达96颗A100 40G;而LLaMA需要2,048颗A100 80G;GPT-3.5估计需要数千到上万颗的A100 80G。

NVIDIA在2022年底推出H100,相较于A100,NVIDIA表示,根据AI测试基准MLPerf的成绩,H100较A100高出4.5倍效能。然H100的价格不菲,且重要的是,现在有钱也买不到,业界传出,H100的供货时间(lead time)长达40~50周,一切都需要NVIDIA统一分配。

林百里日前受访时说,现在不缺订单,唯一问题在于供应链并不顺畅,承接服务器生产的广达如同煮饭,手中没米也没辙。林百里口中的米,指的就是NVIDIA的GPU。众人将缺料归咎于台积电CoWoS供货不足。AI有单没料,凸显台厂关键角色。

台积电董事长刘德音针对缺料解释,台积电CoWoS技术与NVIDIA的CUDA软件都一样发展了15年,只是近期CoWoS先进封装需求暴增3倍,才会供不应求,目前已满足80%需求,台积电也在扩产,1年半后能赶上客户需求,短缺为短暂现象。

短期缺料难解,H100价格也飙高,NVIDIA的H100每片定价达3万美元,某些特殊情况,有机构估H100每片报价可达7万美元。GPU价高,组合成服务器机柜更贵,业界透露,装5台8U的AI机柜,价格达40万美元。广达曾表示,AI服务器机柜较通用(genral purpose)服务器机柜高3倍。

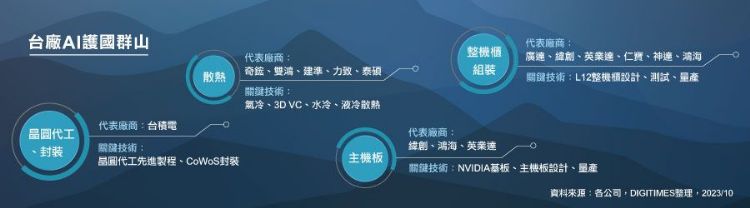

不只台积电 关键零组件与下游组装都是要角

硬件高大尚,又需要大数据喂养,实力坚强的云服务业者舍我其谁,成为拥抱此波生成式AI商机的先行者。DIGITIMES Research估,2023年全球高端AI服务器前4大业者占74.6%,这4家分别是微软(Microsoft)、Google、Meta与AWS。

豪掷数十亿美元投资OpenAI的微软,率先企图将AI变现。微软积极将AI导入旗下各种服务与产品,CEOSatya Nadella在7月底的法说会中指出,Azure OpenAI服务需求强劲,现已有1.1万跨产业企业导入,每天以近100名新客户的速度持续成长。

看好客户对AI强劲需求,微软财务长Amy Hood也指出,将加快对云端基础架构的投资,相关的资本支出,会逐季增加。Google母公司Alphabet也表示,2023财年下半,将提高对科技设备建置的资本支出,且在2024财年会持续增加,主因也是要掌握AI带来的新机会。

美系云服务商所用的数据中心,硬件多数由台厂提供,若单纯以下游的主机板打件及机柜组装来说,富士康、广达、纬颖、英业达、神达都是供应商,其中相关零组件,从散热元件、机构件、电源供应到各种电子件,也多数由台厂供应。

AI改变硬件设计 台厂价值浮现

服务器硬件供应链指出,AI不只创造产品新种类,更因为大运算需求,打造了新规格,也带来了新机会,之前也有AI服务器,然量少,客户会沿用既有产品规格,如今需求大增,客户愿意开新规格,也扩大产品平均单价与利润的拉升空间。

AI服务器运算大,也有更大的散热需求。目前NVIDIA的H100主要搭配气冷散热出货,然由于H100的散热设计功率(TDP)高达700瓦,因此气冷散热设计从原本散热导管+风扇,改为3D VC+风扇。

3D VC是从热板延伸到热管,要将不同真空体结合,不论焊接或压铸,对供应商都是良率的考验,也是进入门槛,更是拉高平均单价的机会。奇𬭎董事长沈庆行曾在法说会指出,将散热导管换成3D VC,价格直接跳2倍。

气冷散热的风扇规格,也随着AI服务器设计不同而改变。风扇厂建准指出,一般服务器所需要的散热风扇,规格为80mmx56mm的单颗马达,然AI服务器的风压与风速需求更大,客户会改用120mm或2颗80mm的风扇,搭配双马达,平均单价因此上扬。

除了气冷,散热厂也都在布局水冷与液冷,水冷是搭配水冷板及管线,将GPU产生的热带到服务器外,再透过风扇或冰水主机后进行散热循环。积极开发AI服务器水冷散热的泰硕指出,水冷系统与原本的热管散热相较,价差甚至高达10倍。

此外,NVIDIA的GPU加上3D VC散热,重量提升,根据研调机构Omdia指出,包括散热器的单颗H100 GPU,重量就超过3公斤,机柜设计也必须改变,包括厚度更厚,且接合处需要锌合金或铝合金强化等,且由于散热鳍片尺寸更大,机箱高度也从1U~2U拉高到4U,平均单价也上扬。

硬件供应商都明白一个道理,新产品的良率低、难做,价格最好,之后大量生产,客户会开始砍价,也会导入第二、第三供应商。如今AI正处于开始阶段,相关硬件需求刚起飞,虽然是黎明时刻,然已可看到未来大放光明的光景,就在不远处。

责任编辑:游允彤