AMD正式向英伟达的AI芯片王者地位发起挑战。

美西时间6月13日,AMD举办了“数据中心与人工智能技术首映会”,CEO苏姿丰亲自上阵揭示Instinct MI300系列、第四代EPYC(霄龙)处理器等AI/数据中心相关产品。

MI300X则是AMD针对大语言模型优化的版本,该产品的晶体管数量达到1530亿个,采用3D小芯片设计(chiplet),结合采用台积电5纳米制程、AMD CDNA 3架构GPU、6纳米IO芯片和HBM小芯片,整体性价比优异,已获得多家大厂支持,势将对NVIDIA GH200超级芯片带来不小压力。

另一方面,随着人工智能(AI)服务器需求大增,相关供应链也受惠迎来新一波成长动能,除了台积电通吃大单外,上下游供应链也雨露均沾。包括亚马逊AWS、Citadel、Hugging Face、Meta、微软Azure和PyTorch等高层也站台力挺AMD。

MI300X第3季送样,ROCm生态系加速扩张

苏姿丰介绍,MI300X可以支持400亿个参数的Hugging Face AI 模型运行,并演示了让这个LLM写一首关于旧金山的诗。这是全球首次在单个GPU上运行这么大的模型。单个MI300X可以运行一个参数多达800亿的模型。

苏姿丰表示,随着模型参数规模越来越大,就需要更多的GPU来运行。而随着AMD芯片内存的增加,开发人员将不再需要那么多数量的GPU,能够为用户节省成本。

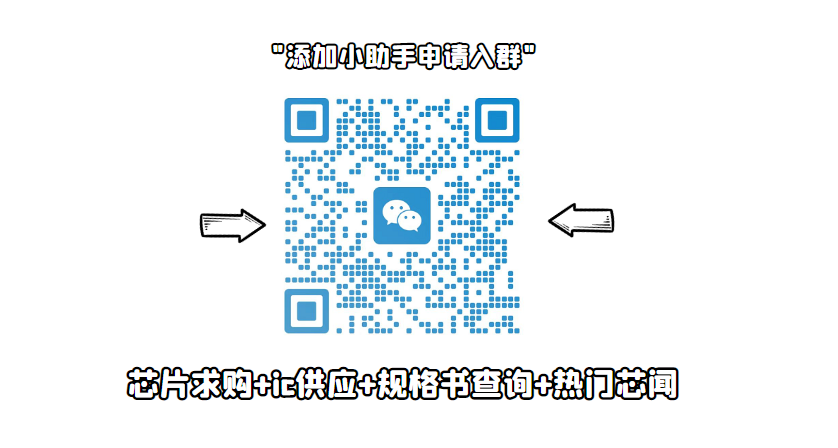

此外,她还透露,适用于CPU和GPU的版本MI300A现在就已出样,MI300X和八个GPU的Instinct 平台将在今年第三季度向一些客户提供样品,第四季度正式推出。

MI300X将于今年第三季度向一些客户提供样品,并于第四季度量产。

值得注意的是,MI300系列采用台积电5/6纳米制程、3D小芯片设计,而NVIDIA H100 GPU,也采用台积电4纳米与CoWos先进封装技术,也就是说,台积电成为最大受惠者,助力下半年5/7纳米家族制程产能利用率回升,且加速扩产CoWoS产能。

急追NVIDIA CUDA,超微ROCm加快部署

好的芯片不仅是产品本身,还需要有一个好的生态。人工智能开发人员历来偏爱英伟达芯片的一个原因是,它有一个开发完善的软件包,称为CUDA,使他们能够访问芯片的核心硬件功能。

为了对标英伟达的CUDA,AMD推出了自己的芯片软件“ROCm”,打造自己的软件生态。

AMD总裁Victor Peng称,在构建强大的软件堆栈方面,AMD取得了真正的巨大进步,ROCm软件栈可与模型、库、框架和工具的开放生态系统配合使用。

新增Bergamo,锁定云瑞原生应用需求

在介绍了MI300的同时,AMD在今天还介绍公司了另一款重头戏产品——新一代的EPYC。

这是一系列为数据中心设计的芯片,到了第四代,AMD则准备了四条针对不同市场的产品线,当中更是包括了备受关注的、以云原生计算需求为目的的Bergamo系列以及代号为Genoa-X的第二代 EPYC 3D V-Cache CPU。据了解,“Genoa”采用台积电5纳米制程,支持PCIe 5.0及CXL存储器扩充技术,可支持12个通道的DDR5。

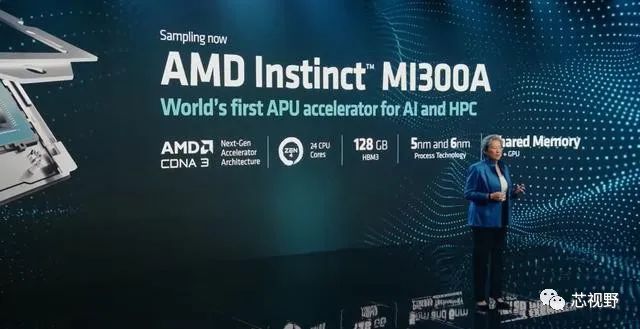

据苏姿丰介绍,新一代的AMD EPYC Genoa 在云工作负载中的性能是英特尔竞争处理器的 1.8 倍,在企业工作负载中的速度是英特尔竞争处理器的 1.9 倍。

在介绍了EPYC Genoa之后,苏姿丰着重介绍了公司的云原生产品Bergamo。据介绍,该芯片基于AMD的密度优化Zen 4c架构,提供多达128个CPU内核,比AMD当前一代旗舰EPYC 9004“Geona”芯片多32个内核,锁定更高密度的云瑞原生应用需求。

瞄准云端与企业,更多芯片在路上

AMD此前通过收购Pensando获得DPU技术。此次AMD称,其P4 DPU架构是世界上最智能的DPU,它能减少数据中心的网络开销,并提高了服务器的可管理性。AMD的Pensando SmartNICs是这种新数据中心架构不可或缺的组成部分。

AMD 同时强调了其代号为“Giglio”的下一代 DPU 路线图,与当前一代产品相比,该路线图旨在为客户带来更高的性能和能效,预计将于 2023 年底上市。

AMD 还发布了 AMD Pensando Software-in-Silicon Developer Kit (SSDK),使客户能够快速开发或迁移服务以部署在AMD Pensando P4可编程DPU上,与AMD上已经实现的现有丰富功能集相协调Pensando 平台。