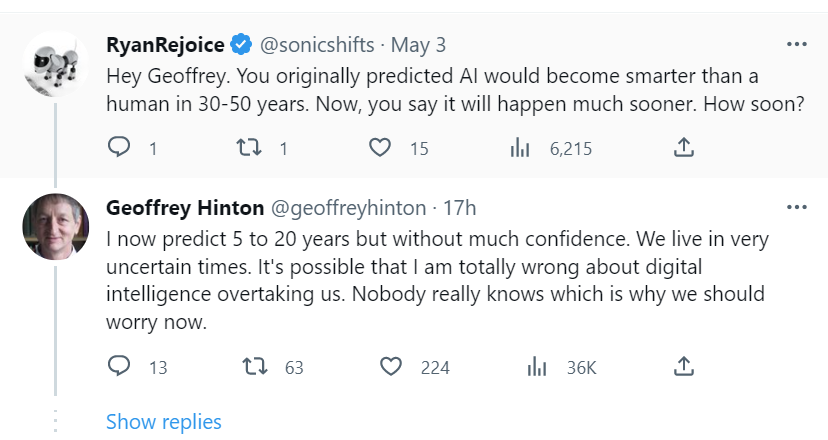

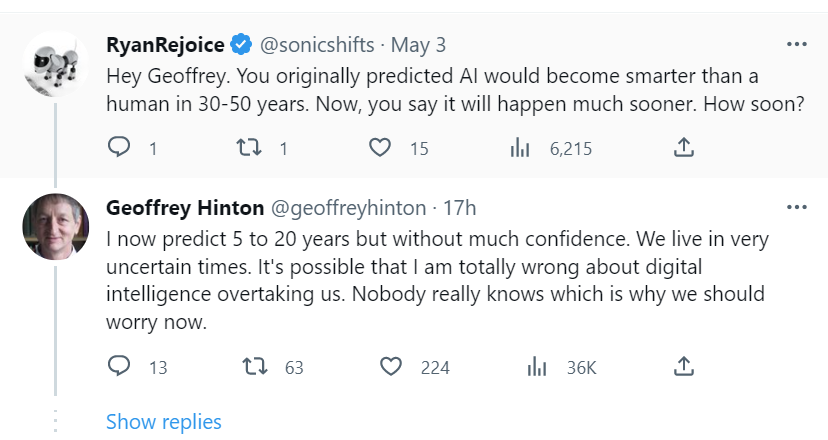

电子工程专辑讯 近日,在谷歌工作10年有余的杰弗里·辛顿( Geoffrey Hinton)在社交平台上证实已经从谷歌离职。杰弗里·辛顿表示,离开谷歌不是为了批评谷歌,实际上是为了能更自由的谈论人工智能的危机。早前,杰弗里·辛顿最初预测人工智能将在未来30-50年内变得比人类更聪明,不过他现在认为这个时间节点会发生的更快,杰弗里·辛顿预测时间可能会提早到5-20年,不过没有什么信心,我们生活在非常不确定的时代,关于人工智能超越人类,没有人真正知道,这也正是我们现在应该担心的。杰弗里·辛顿生于1947年12月6日,以类神经网络方面的贡献而闻名。辛顿是反向传播算法和对比散度算法的发明人之一,也是深度学习的积极推动者,被誉为“深度学习之父”。辛顿因在深度学习方面的贡献与约书亚·本希奥和杨立昆一同被授予了2018年的图灵奖。辛顿于1970年在英国剑桥大学获得实验心理学学士学位。此后于1978年在爱丁堡大学获得人工智能博士学位。此后曾在萨塞克斯大学、加州大学圣迭戈分校、剑桥大学、卡内基梅隆大学和伦敦大学学院工作。他是盖茨比计算神经科学中心的创始人,目前担任多伦多大学计算机科学系教授。辛顿是机器学习领域的加拿大首席学者,也是加拿大高等研究院赞助的“神经计算和自适应感知”项目的领导者。辛顿在2013年3月加入Google,同时Google并购了他创办的DNNresearch公司。据《纽约时报》消息,辛顿证实了对人工智能未来发展的担忧,他表示随着各大科技公司改进人工生成智能系统,人工智能经常从分析大量数据中学习意想不到的行为,人工智能将变得越来越危险。辛顿之前认为,谷歌、OpenAI和其他公司建立的从大量数字文本中学习生成式人工智能网络,是一种让机器理解和生成语言的强大方式,但它不如人类处理语言的方式。但是随着如ChatGPT这样的聊天机器人的火爆,辛顿的观点发生了改变。他对生成式人工智能可能带来的风险有了更深刻的了解。近年生成式AI初创企业的投资热度高涨,根据商业研究公司CB Insights的一份报告,2022年投资者向110笔针对生成式AI初创公司的交易投入了超过 26亿美元,这是该领域投资的历史新高。在2022年第四季度所有行业规模最大的风投交易中,有两笔是针对生成式AI初创企业的。生成式人工智能的研发竞争不会停止,这也将迫使人类面临充斥着假图片和假文字的世界,真相会变得难以辨识。而人工智能制造的大量错误的信息,将影响人们的判断和决策。AI也将颠覆就业市场,比如ChatGPT聊天机器人可以协助我们工作的完善,取代律师助理、个人助理、翻译,或者其他死记硬背的工作,“它带走苦差事,也可能会带走更多的东西”,辛顿表示。辛顿的言论引发了外界猜测,他是否在批评谷歌的猜想。不过辛顿对此澄清说,他之所以公开谈论人工智能的风险,是因为他已经不受谷歌的限制,可以自由谈论人工智能所带来的危机。辛顿的观点并不是一家之谈,由非营利性的“生命的未来研究所 "人工智能(AI)行业专家在3月28号的一封公开信中,呼吁暂停开发比OpenAI最近推出的GPT-4更强大的生成性AI系统,理由是对社会和人类的潜在风险。这些系统可能会造成经济和政治混乱,并呼吁开发者与政策制定者和监管者合作。共同签署者包括稳定人工智能公司的首席执行官埃马德-莫斯塔克、Alphabet旗下DeepMind公司的研究人员以及人工智能大师约书亚-本吉奥和斯图尔特-拉塞尔。该公开信说:"只有当我们确信强大的人工智能系统的影响是积极的,其风险是可控的,才应该开发。"签署该信的纽约大学教授加里-马库斯(Gary Marcus)说:"这封信并不完美,但精神是正确的:我们需要放慢脚步,直到我们更好地了解其影响。" 他指出,"大公司对他们正在做的事情越来越保密,这使得社会难以抵御可能发生的损害。"埃隆·马斯克在阿联酋迪拜的2023年世界政府峰会上表示,ChatGPT证实了人工智能(AI)已经获得了令人难以置信的发展,但这已成为人类应该担心的一件事。人工智能是未来人类文明最大的风险之一。他补充称,“它有积极的一面,也有消极的一面,有巨大的前景也有巨大的能力,但随之而来的危险也是巨大的。”著名物理学家斯蒂芬·霍金曾在2017全球移动互联网大会(GMIC)上发表《让人工智能造福人类及其赖以生存的家园》的主题演讲上提出了“人工智能的崛起可能是人类文明的终结”的观点。霍金指出,文明所提产生的一切都是人类智能的产物,生物大脑可以达到的和计算机可以达到的,没有本质区别。因此,它遵循了“计算机在理论上可以模仿人类智能,然后超越”这一原则。当我们将无限得到人工智能帮助的同时,我们的文明也可能被它毁灭,尽管现在只是替代工作岗位。从短期和长期来讨论人工智能的研究,短期担忧如无人驾驶方面,从民用无人机到自主驾驶汽车,如果在紧急情况下,一辆无人驾驶汽车不得不在小风险的大事故和大概率的小事故之间进行选择。另一个担忧在致命性智能自主武器,他们是否该被禁止?如果是,那么“自主”该如何精确定义。如果不是,任何使用不当和故障的过失应该如何问责。还有另外一些担忧,由人工智能逐渐可以解读大量监控数据引起的隐私和担忧,以及如何管理因人工智能取代工作岗位带来的经济影响。长期担忧主要是人工智能系统失控的潜在风险,随着不遵循人类意愿行事的超级智能的崛起,那个强大的系统威胁到人类。这样错位的结果是否有可能?如果是,这些情况是如何出现的?我们应该投入什么样的研究,以便更好的理解和解决危险的超级智能崛起的可能性,或智能爆发的出现?当前控制人工智能技术的工具,例如强化学习,简单实用的功能,还不足以解决这个问题。因此,我们需要进一步研究来找到和确认一个可靠的解决办法来掌控这一问题。霍金还提到,在库布里克的电影《2001太空漫游》中,出故障的超级电脑哈尔没有让科学家们进入太空舱,但那是科幻。我们要面对的则是事实。奥斯本·克拉克跨国律师事务所的合伙人,洛纳·布拉泽尔在报告中说,我们不承认鲸鱼和大猩猩有人格,所以也没有必要急于接受一个机器人人格。但是担忧一直存在。报告承认在几十年的时间内,人工智能可能会超越人类智力范围,进而挑战人机关系。本文参考自路透社、推特、Newtalk、维基百科、腾讯科技等报道

[ 新闻来源:电子工程专辑,更多精彩资讯请下载icspec App。如对本稿件有异议,请联系微信客服specltkj]

全部评论