顾名思义,专业的图形处理单元(GPU)最初是在几十年前设计的,用于高效地执行图像和视频处理等常见的操作。这些过程以基于矩阵的数学计算为特色。人们通常更熟悉中央处理器(CPU),它存在于笔记本电脑、手机和智能设备中,可以执行许多不同类型的操作。

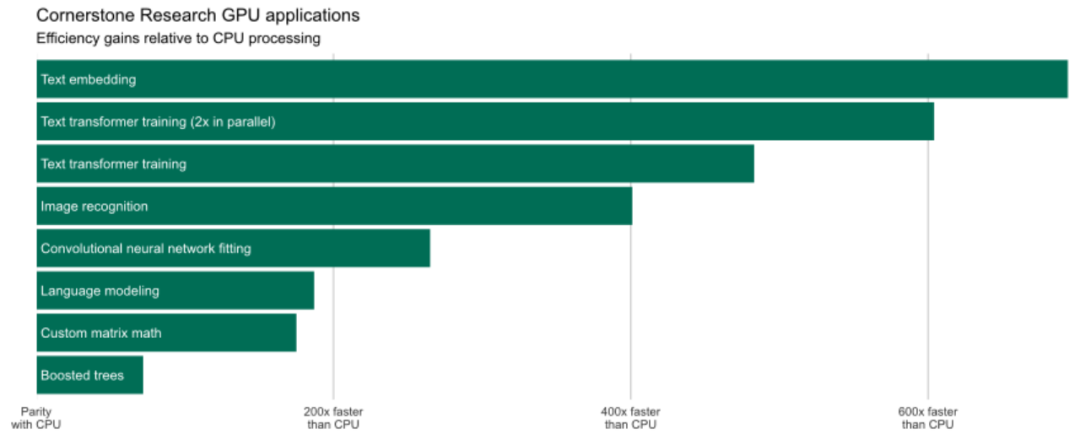

使用GPU最关键的好处就是效率高。GPU提供的计算效率不仅仅是简化了分析过程,它还促进了更广泛的模型训练以获得更高的准确性,扩大了模型搜索过程的范围以防止替代规范,使以前无法实现的某些模型变得可行,并允许对替代数据集增加额外的敏感性以确保其稳健性。

GPU如何支持专家证词?

基于人工智能的系统用数据驱动的决策取代了人类决策。这可以使得在处理大量复杂信息时减少主观性和错误。我们利用人工智能和机器学习来推动越来越复杂的任务的自动化,并解锁新的分析方法,包括使用监督和非监督学习,这些技术都由我们内部的GPU支持。

矩阵运算

GPU使我们能够快速地执行自定义矩阵运算。例如,在反垄断问题中,我们经常需要计算所有供应商和所有消费者之间的距离(坐标对)。将计算从CPU迁移到GPU使我们能够每秒计算近1亿个坐标对之间的距离。

围绕基于GPU计算的许多关注的重点都集中在神经网络上。虽然能够处理常规的分类和回归问题,但附加的特定于任务的神经网络体系结构为文本、图像和声音的特定分析提供了一个框架。考虑到这些模型的复杂性和生成可靠结果所需的数据量,如果没有GPU计算资源,它们的使用实际上是无法实现的。当在GPU上训练一个流行的多类图像模型时,与在单个CPU上运行相同的进程相比,我们体验到了25,000%的速度提高。我们在针对消费者欺诈问题的内容分析中利用了这种效率,我们设计文本和图像分类器来表征有问题的营销材料的目标受众。

语言模型

语言模型通常基于一种或多种深度学习技术,可以对文本进行分类、解析和生成。我们使用大型语言模型来提取特定的信息片段,解析实体之间的关系,识别语义关系,并在文本分类问题中补充传统的基于术语的特征,例如在诽谤事件中量化围绕公共实体的社交媒体情绪。

GPU和与其相关的软件将继续发展。新的硬件可能具有更多的内核、更快的内核和更多的内存,以适应更大的模型和数据批。新的软件可能会使跨多个GPU,共享模型和数据变得更加容易。

其他发展可能涉及完全不同的设备。为了解决GPU计算中仍然存在的一些效率低下的问题,机器学习从业者越来越多地转向应用特定的集成电路(ASIC)和现场可编程门阵列(FPGA)。例如,谷歌的张量处理单元(TPU)是一个专门为其机器学习TensorFlow软件包执行计算而设计的ASIC。FPGA提供了更大的灵活性,通常用于在需要低延迟、高带宽和最低能耗的生产环境中部署机器学习模型。

END

(添加请备注公司名和职称)