上周六,DT 君在柏林 IFA 现场深度报道了华为最新发布的移动端 AI 芯片。此后,DT 君独家专访了深度参与麒麟 970 方案设计的一位相关人士,但这位相关人士拒绝在文章中透露其姓名及身份。

本文引用地址:http://www.eepw.com.cn/article/201709/363905.htm这位相关人士表示,麒麟 970 整合NPU(Neural Processing Unit,神经处理单元)构想早在五年前就已经开始酝酿。

就当初的情况而言,产业界已经看到 CPU 的应用瓶颈,而 GPU 虽然也开始参与计算工作,但其主要的显示工作随着分辨率的提高而负担不断加重,所以要让这个已经分身乏术的架构继续增加负荷,对整体性能以及功耗表现也是会产生负面影响。

可以说,为追求更高的应用效率,以及更好的功耗表现,只让 CPU 或 GPU 架构参与计算已经远远不够满足需求。

事实上,当初的主流移动芯片架构也已经不会只内建此两种架构,而多半会增加额外的 DSP 单元或者是 ISP 架构,不仅分担主系统的沉重计算负担,也因为让不同类型的计算工作可以摆到更适合的计算架构上,整体功耗也有了明显的改善。

可以说,AI 正是基于同样的概念:让适合的架构来做适合的工作,效率才会得到提高。

图丨余承东展示麒麟970

这位相关人士对 DT 君表示,华为在当时就决定了未来 AI 相关计算,将会以专用架构的设计方式进行,这就好比绘图工作会交给 GPU 而不是 CPU 是一样的道理。

寒武纪的生态经营和架构优势赢得华为青睐

当然,以华为旗下海思的芯片设计功力,如果要从无到有设计出专用的 NPU 单元,也不是不可能的事情——此类 NPU 架构单纯,设计难度也不会比 CPU 更高,但问题出在生态方面。

这位相关人士表示,如果完全自主开发,从无到有的经营生态,华为有可能在未来方案推出时,缺乏市场开发者以及相关生态的支持,恐怕结果只会是事倍功半。

众所周知,寒武纪的前身是中国科学院计算技术研究所下的一个课题组,由陈云霁、陈天石教授领导。

该课题组早在 2008 年就已经开始研究神经网络算法以及芯片设计。寒武纪第一代方案在 2012 年推出,65nm 工艺下功耗为 0.485W,面积 3.02mm²。平均性能超过主流 CPU 核的 100 倍,但面积和功耗仅为 1/10,表现相当惊人。

图丨寒武纪1A处理器(Cambricon-1A)

不过,当初寒武纪有个非常直白的命名代号,叫做 DianNao,就是中文拼音的“电脑”——顾名思义就是拿来做计算工作的、用电的“大脑”。当初,这个命名并不是中国人的主意,而是研究团队中法国人的建议——不用当时已经烂大街的神经网络芯片之类的命名,反其道而行用中文取名,外国人反觉得十分高大上,相当有趣。

中科院在 DianNao 的基础上开发出 DaDianNao(第二代,功能增强)、PuDianNao(第三代,普电脑,通用型机器学习晶片)、ShiDianNao(视电脑,图像识别处理器)、DianNaoYu(电脑语,神经网络指令集)等延伸规格,针对不同应用或目的特化,也看得出研究团队对命名规则的坚持。

这位相关人士对 DT 君表示,寒武纪实际上是基于对整个软硬件优化的平台,拥有成熟的硬件,以及软件界面设计,生态支持能力绝佳,且因为知识产权完全自有,不怕受制于人。也因此,华为一方面为了节省成本,一方面又要有足够竞争优势的架构设计,考量二者得出的唯一解答:就是寒武纪了。

图丨寒武纪科技

NPU到底有多强大?

NPU 本身可达到 1.92 TFLOPS 的半精度(16bits)计算能力,以 IFA Keynote 上提到的应用案例为例,使用 NPU 可在一分钟内辨识超过两千张图片。换句话说,每秒可辨识超过 30 张图片,这对于需要及时分析的场景识别或者是合成,所需要的数据分析,已经可以达到几乎实时的地步。

而就华为给出的 25 倍速度,50 倍效率推算,该 NPU 功耗全负载大约只有 CPU 的一半,如果以计算效率/功耗换算,大概是 0.8 TFLOPS/W,如果以 NVIDIA 的 V100 方案作比较,V100 约为 0.4 TFLOPS/W。

可见,麒麟970内建的 NPU 效率之高了。

从云端到本地端硬件的AI应用

DT 君在之前的报道分析中也提及,云端性能强大,学习快速,但学习得出来的模型是通用模型,很难针对小众有订制化的调整,并满足消费者的应用场景。

但过去本地端硬件性能不足,虽然可通过云端学习,但数据这么一来一往,效率极低,无法做到实时处理。若本地端硬件拥有强大的 AI 学习能力,那么就不需要把数据上传到云端,直接在本地端处理即可,效率更高,且更能确保数据的安全与隐私。

这位相关人士表示,环顾业界,其实不是只有华为在做终端的 AI 计算工作,但华为提出的方案是以能够实现快速规模化,并以成熟的商业思维为基础。其他竞争业者,比如说高通或苹果,也都在各自的技术领域有所成就。

然而,这个市场目前才处于刚刚在酝酿的时期,所以根本也不存在什么竞争问题。如果产业竞争者能够共同把饼做大,让生态更成熟,其实整个 AI 的市场规模足以撑起许多大型企业,而华为抢先卡位,自然是为了届时能够处在一个相对优势的市场地位。

但任何事物的发展都需要时间,所以只有把眼前的移动生态先做好,未来才能够实现对其他应用场景的布局。

那么生态系统的支持如何拓展?不同架构是否会冲突?

当然,目前业界采取的 AI 加速芯片设计,在结构和理念上都各有不同,计算特性也不一致,但这名相关人士表示,其实也不用担心未来会有不同架构各据山头,导致生态撕裂、饼做大前先起内讧的状况出现。

由于目前主流操作系统(包括Windows、Linux或Android)都已经支持了针对终端 AI 计算的相关开放规范,也提供了共同的软件界面,从而借以接入各种不同架构的 AI 加速芯片。

未来 AI 加速芯片的设计会有标准功能,也会有作为差异化速求的额外附加功能,前者透过一般标准界面就可存取,后者也同样是透过标准界面,但只需要小幅修改开发者端的程式码即可取用,不会造成业界的混淆。

移动应用是短期目标,未来将打生态战拓广其他领域

这位相关人士也表示,华为在 IFA 上的应用方向其实是短期目标,由于手机生态成熟,也容易接受新技术的导入,而把 AI 加速能力放在手机方案上,最有机会得到回报。

就当前的三大应用方向而言,包含视觉处理、AR 以及自然语言,都是近来最热门的高端智能手机应用发展方向,如果华为能够用更低的功耗,更好的效率来处理好这些事情,一来可以提升品牌价值,创造更高的利润,二来熟悉相关终端 AI 处理技术之后,也可以把这些方案拓展到其他智能应用上,而不是只有手机而已。

这位相关人士也强调,华为内部也已经有下一个三年计划,针对未来 AI 技术的演进,配合市场应用的需要来进行改善和微调,并随着麒麟芯片的世代更替来推新架构。

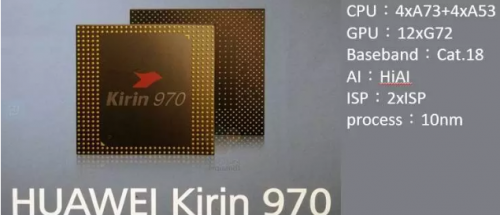

图丨麒麟 970的细部架构,NPU是最大亮点(资料来源:华为)

然而,虽然目前手机上的 AI 方案主要都着眼于 Inference(推理),而 Learning(学习)的部分则较少被提及。但凭借 NPU 的导入,一旦性能足够之后,要做到小规模的学习也不是不可能的事情,这部分与个人化的使用体验息息相关,各大厂都不会轻易放过这块大饼。

初期以高端方案布局NPU应用,未来将可能打入中端市场,扩大生态的发展

麒麟 970 作为第一代整合 NPU 的应用处理器芯片,定位最高端,也不吝于用最好的工艺,搭最顶尖的计算核心,但考虑到未来市场的走向,AI 应用一定会普及化、平民化,所以未来在相关 AI 芯片的布局规划上,肯定会往中端,甚至低端的方向走,但是在 NPU 的规模方面恐怕就会有所调整,一方面是成本考量,一方面也是产品定位问题。

目前,华为正在积极和第三方软件开发商合作,希望将整个生态基础快速扩大,这方面也不会仅止于 IFA 上所公布的三大应用方向,而是会鼓励产业合作伙伴积极尝试,华为也会尽力协助合作厂商做出他们想要的 AI 应用。

这位相关人士表示,麒麟 970 的发表只不过是短期指标,长期来看还有不少需要加强的地方,但华为至少已经踩出第一步了。虽不能说就已经是立于不败之地,但至少快了竞争对手一些,也让华为可以提早思考下一步的布局。